智谱多模态开源周项目总结:智谱一周开源总结:从多模态到语音交互

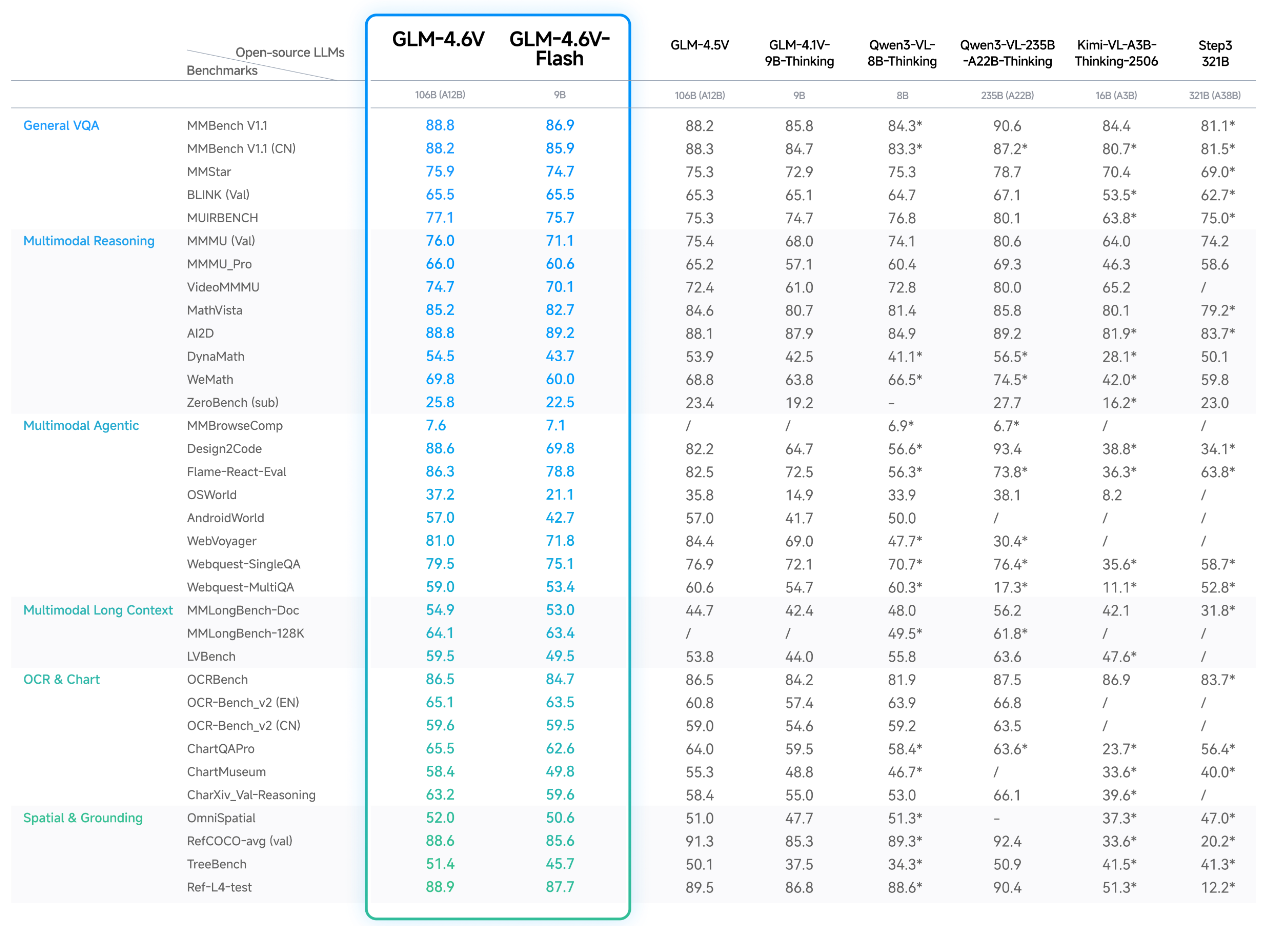

2025 年,多模态大模型迎来了“从理解到行动”的关键转折点。12月8日智谱AI发布的 GLM-4.6V 系列,不仅是其多模态路线的最新成果,更是整个行业首次将视觉理解、工具调用、长上下文、多模态输出真正融为一体的开源大模型体系。

部分内容已折叠,查看完整文章请先登录。 登录后查看完整文章

这些都将变得比以往更容易、更低成本。

原创文章,更多AI科技内容,微信搜索 橙 市 播 客小程序

声明:本站所有文章,如无特殊说明或标注,均为橙市播客原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。如果你是AI总结,务必加上此版权说明