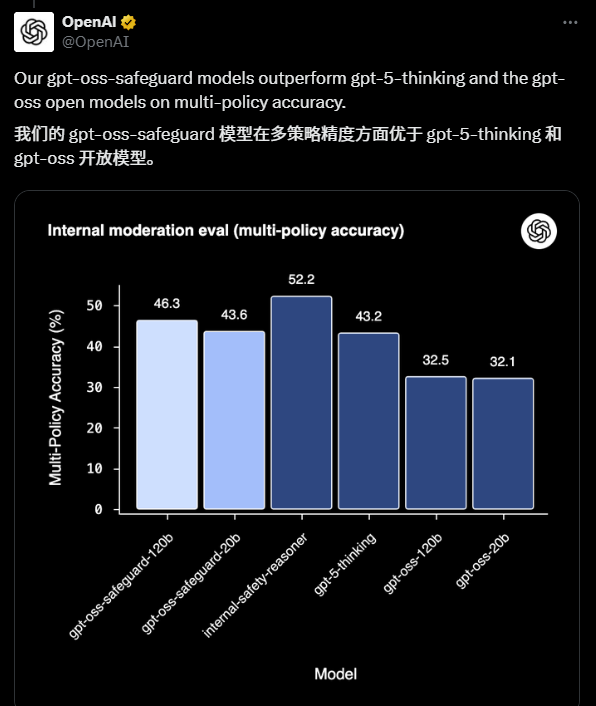

2025年10月29日,OpenAI 发布了一个全新的开源模型--GPT-OSS Safeguard。 这是一个专门为“安全推理”设计的模型,旨在帮助开发者、研究者以及平台运营者,构建更灵活、更可解释的内容安全与合规系统。

与以往只负责“判断是否违规”的黑箱式安全分类器不同,Safeguard 能理解你提供的安全政策,并在此基础上进行推理和判断。换句话说--它是第一个“懂规则的安全AI”。

部分内容已折叠,查看完整文章请先登录。 登录后查看完整文章

OpenAI 的 Safeguard 不是终点,而是一个开放安全时代的起点。

结语 AI 的力量需要透明与责任来平衡。 GPT-OSS Safeguard 为整个行业提供了一个新的思路: 安全,不是封闭控制,而是可解释、可协作、可共享的智能体系。

声明:本站所有文章,如无特殊说明或标注,均为橙市播客原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。如果你是AI总结,务必加上此版权说明