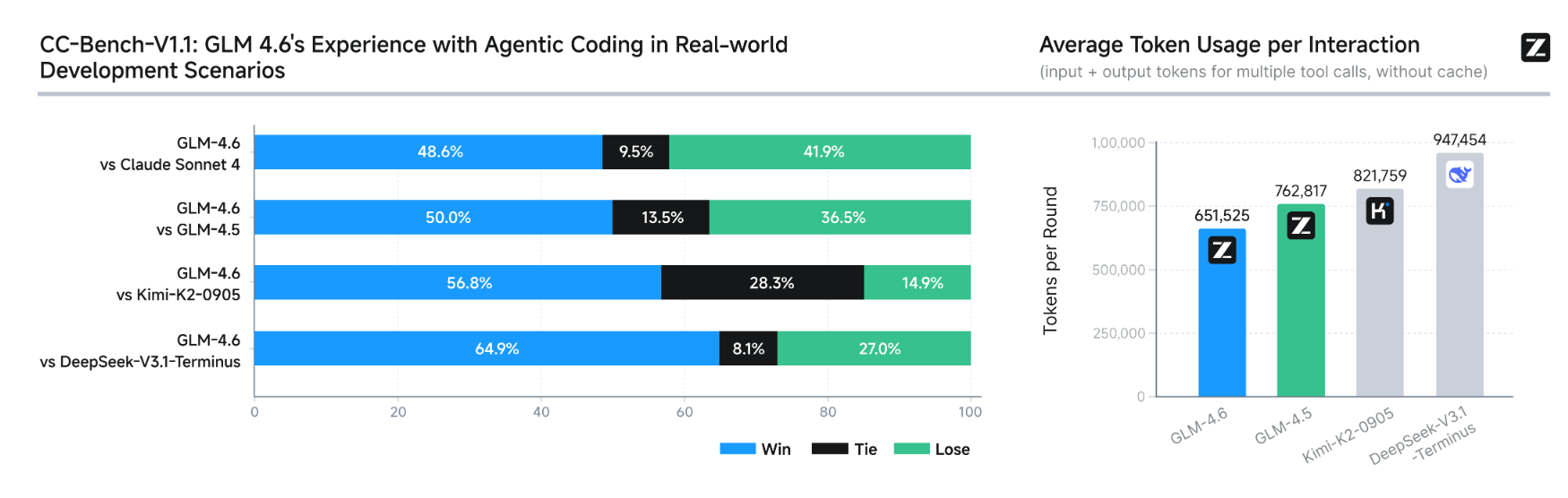

2025 年 9 月 30 日,智谱 AI(Zhipu)毫无预警地甩出一张“王炸”--GLM-4.6。 这一次,它不再只是“中文社区最爱”,而是把枪口直接对准了全球开发者最挑剔的赛道:长上下文 + 编程 + 智能体。 机器之心在第一时间拿到内测资格与内部报告,为你拆解这款被内部代号称为“Sonnet Killer”的模型,到底杀到哪一层。

200 K 并非“数字游戏”。智谱把内部最耗上下文的三大场景--

部分内容已折叠,查看完整文章请先登录。 登录后查看完整文章

当大模型进入“工程化落地”深水区,成本每下降 10 倍,就会出现一波新应用。 GLM-4.6 把门票价格打到 ¥24/1M tokens,相当于让每一次 10 万行代码审查,只需 一杯奶茶钱。

开发者们,准备好迎接下一波“代码爆发”了吗?

声明:本站所有文章,如无特殊说明或标注,均为橙市播客原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。如果你是AI总结,务必加上此版权说明