在人工智能蓬勃发展的当下,大语言模型处理长文本的效率与成本难题,一直是制约技术落地的关键瓶颈。2025 年 9 月 29 日,深度求索公司重磅发布 DeepSeek-V3.2-Exp 实验性版本,宛如一颗璀璨新星,为这片困境带来了破局之光。

部分内容已折叠,查看完整文章请先登录。 登录后查看完整文章

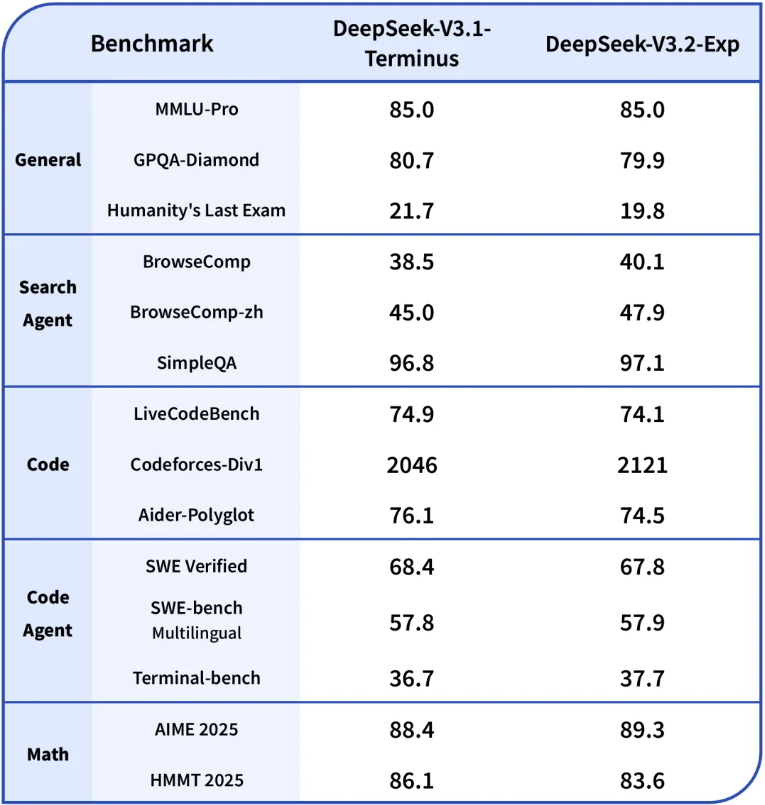

对比测试文档:

反馈链接:

声明:本站所有文章,如无特殊说明或标注,均为橙市播客原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。如果你是AI总结,务必加上此版权说明