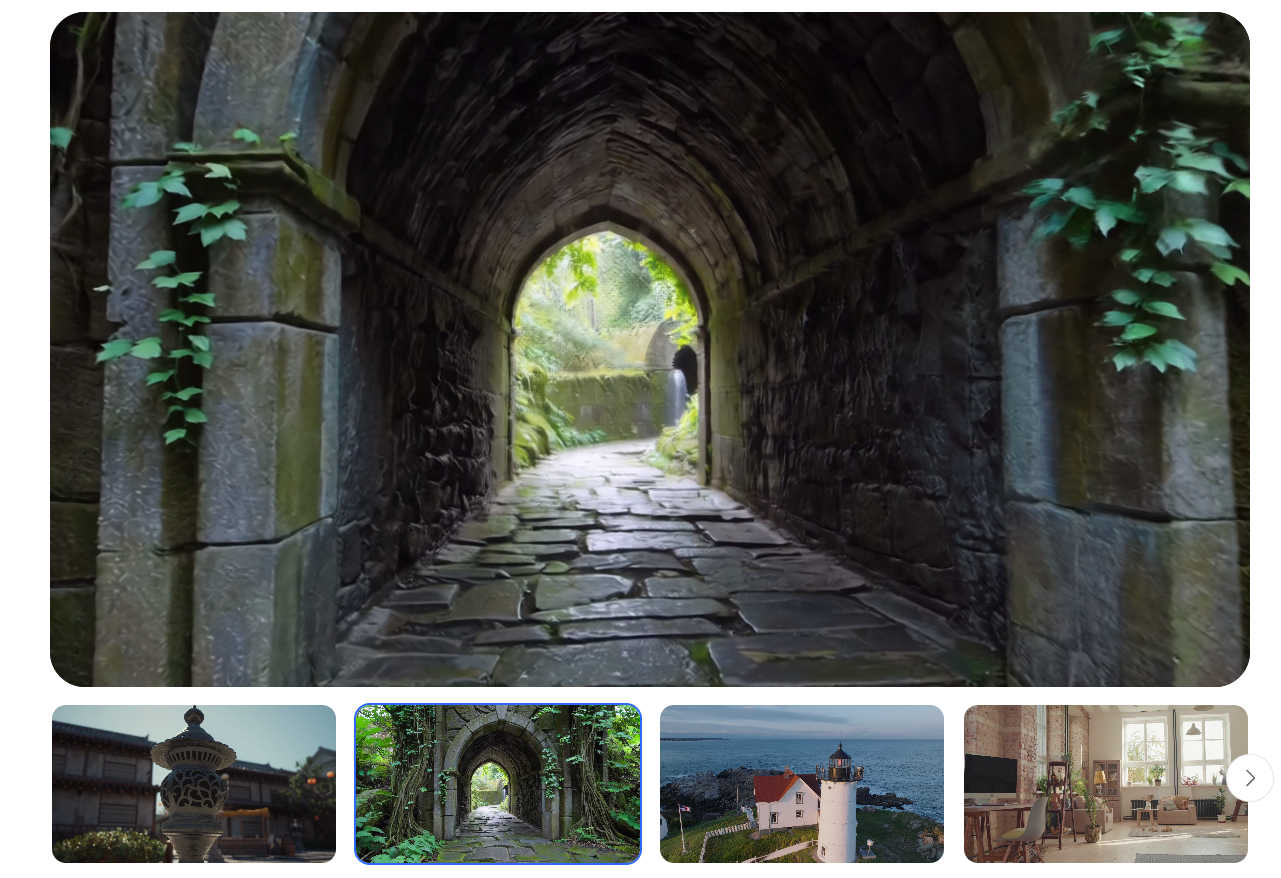

把一段手机随手拍的视频扔进电脑,几秒钟后,你就能在屏幕里自由穿梭--低头看见地砖的裂缝,抬头望见吊灯的细节,转身俯瞰整个客厅的布局。这不是游戏彩蛋,而是腾讯混元最新开源的WorldMirror 1.1(代号:WorldMirror)带来的"魔法"。

部分内容已折叠,查看完整文章请先登录。 登录后查看完整文章当3D重建不再是博士论文,而是pip install就能用的API, "人人造世界"的时代,正式开幕。

🌟 快去试试吧,下一段10秒视频,就是你心中的元宇宙入口。

声明:本站所有文章,如无特殊说明或标注,均为橙市播客原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。如果你是AI总结,务必加上此版权说明