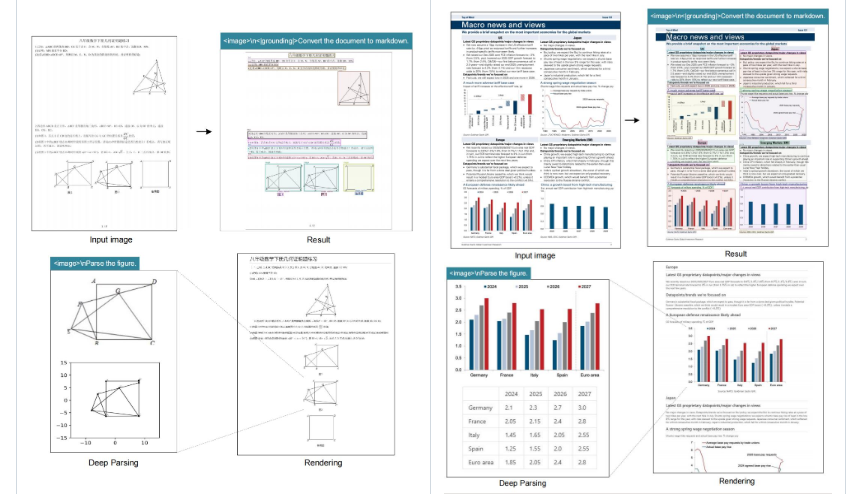

多模态大模型(LVLM)的标配流程是: 图像 → 视觉编码器 → 上千视觉 Token → LLM。 一旦文档页数上来,上下文窗口瞬间爆炸,速度、成本、精度全线崩溃。

部分内容已折叠,查看完整文章请先登录。 登录后查看完整文章

DeepSeek-OCR 把“识别”升维成“压缩”,让 LLM 以 极低 Token 成本 吞下整座文档图书馆。 当视觉通道不再是瓶颈,多模态 RAG、实时论文助手、全库问答、机器人流程自动化都将迎来新的“速度-成本”拐点。

现在就 git clone 一张 GPU,把 PDF 变成 64 个 Token 喂给你的大模型吧--

世界那么大,一页就装下。

声明:本站所有文章,如无特殊说明或标注,均为橙市播客原创发布。任何个人或组织,在未征得本站同意时,禁止复制、盗用、采集、发布本站内容到任何网站、书籍等各类媒体平台。如若本站内容侵犯了原著者的合法权益,可联系我们进行处理。如果你是AI总结,务必加上此版权说明